Rund 50 % der FahrerInnen nutzen heute Sprachbefehle in Fahrzeugen, zum Beispiel um das Navigationssystem zu steuern, eine Playlist zu starten oder sich Nachrichten vorlesen zu lassen. Wie im Smart-Home-Umfeld basieren Sprachassistenten in Fahrzeugen auf ausgefeilten und vielfach erprobten Sprachmodellen, die dafür sorgen, dass Sprachbefehle korrekt verstanden und ausgeführt werden.

Kategorie: Client Projects

Hello Car: Spracherkennung in Fahrzeugen

Wie funktioniert Spracherkennung in Fahrzeugen eigentlich? Und welche Technologien und Expertise stecken dahinter? emagine unterstützt seit 2019 führende Automobil- und Softwarehersteller für Sprachtechnologie in der Umsetzung von Sprachsteuerung in Fahrzeugen mit einem eigenen Team aus ComputerlinguistInnen, EntwicklerInnen und Data Scientists. Ein Blick hinters Cockpit und in die Zukunft.

24. Juli 2023

Von Sprache zu Text zu Code zu Aktion: So funktionieren Spracherkennung und Sprachverarbeitung in Fahrzeugen

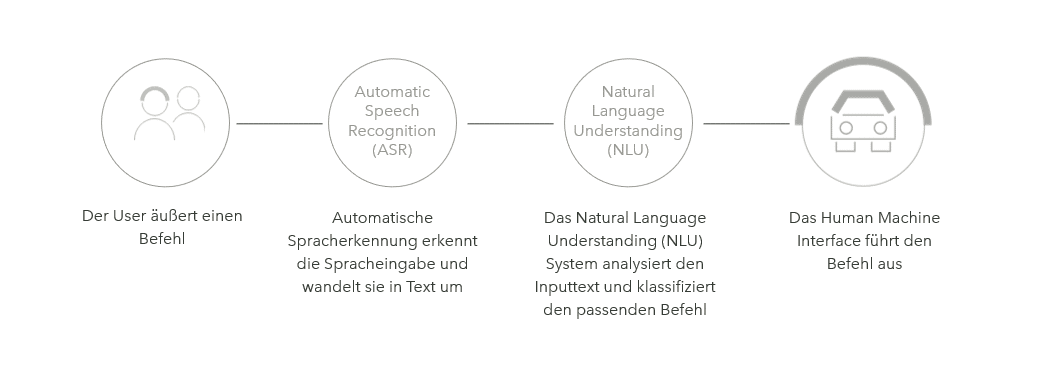

Damit ein Fahrzeugcomputer die Äußerung eines Sprachbefehls korrekt verstehen und fehlerfrei ausführen kann, muss die Software des Fahrzeugs mit den entsprechenden Sprachdaten und -datenmodellen „gefüttert“ werden. Das heißt, eine Spracheingabe muss in ein technisch verarbeitbares Format umgewandelt werden. So wird Sprache zu einer Aktion:

Vorbereitung

Die Aktionen, die ein Fahrzeug ausführen soll, werden festgelegt: einen Telefonanruf starten, die Klimaanlage kühler einstellen, ein Ziel ansteuern. Welche diversen Sprachbefehle würde ein Fahrer nutzen, um beispielsweise die Aktion „einen Telefonanruf starten“ auszulösen? „Rufe [Person abc] an“ oder „Starte Anruf mit [Person abc]“ oder oder oder. Ganz gleich wie der Fahrer den Befehl formuliert – das Auto soll eine bestimmte Aktion durchführen. Diese diversen Äußerungsvarianten werden ebenfalls definiert.

Seit 2019 beraten und begleiten wir führende Automobil- und Softwarehersteller für Sprachtechnologie in der Umsetzung von Sprachsteuerung in Fahrzeugen.

Seit 2019 beraten und begleiten wir führende Automobil- und Softwarehersteller für Sprachtechnologie in der Umsetzung von Sprachsteuerung in Fahrzeugen.

Sven Greiser, Account Director CUI

Data Science & Programmierung: Von Sprache …

Dann beginnt die Datenarbeit: Sprachdaten werden gesammelt, d. h. von Muttersprachlern eingesprochen oder verarbeitet. Schritt für Schritt entstehen so umfangreiche Korpora, also Sprach- bzw. Datenmodelle, welche die statistische Komponente bilden. Für jede Sprache braucht es eigene Korpora mit eigenen Regeln.

… zu Text …

Die Sprachaufnahmen im Audioformat werden per Computer in ein Textformat umgewandelt. Je mehr unterschiedliche Varianten für ein und denselben Befehl vorliegen, desto besser ist eine Spracheingabe unterfüttert und desto genauer kann das Fahrzeug später die gewünschte Aktion ausführen. In diesem Schritt der Transkription werden die Textdaten auch kategorisiert und mit Labels und Schlagworten annotiert: Rufe an <=> Telefon. Der Prompt wird so mit dem richtigen Thema gemappt.

… zu Code …

Mithilfe gängiger Programmiersprachen wie Python und Powershell werden nun verarbeitbare Codes und Skripte erstellt. Menschliche Sprache wird zu Computersprache. Unzählige Datenmengen werden zu einem Sprachmodell.

… zu Aktion

Basierend auf den Informationen, die im Code hinterlegt sind, führt die Software den gewünschten Befehl in gewünschter Form aus. In unserem Beispiel: Die Telefonverbindung (nicht Video) zum Gesprächspartner abc (nicht xyz) wird hergestellt (nicht unterbrochen).

Simpel in der Anwendung, komplex in der Technologie. Hinter ASR und NLU stecken Millionen von Datensätzen und -modellen von emagine – pro Sprache!

Wurde die Fahrzeugsoftware erfolgreich programmiert, passiert – vereinfacht dargestellt – im Fahrzeug folgendes:

- Der Fahrer macht eine Äußerung.

- Die Automatische Spracherkennung (Automatic Speech Recognition – ASR) erkennt die Spracheingabe und transkribiert sie in Text.

- Die Software analysiert diesen Text und klassifiziert das Thema, indem sie diese mit den für die einzelnen Sprachen geschriebenen Regeln abgleicht.

- Wurde der Befehl einwandfrei zugeordnet, reagiert das Dialogmanagementsystem (auch Human Machine Interface) mit der Aktivierung der Funktion (startet den gewünschten Anruf) oder erzeugt eine Sprachantwort („Bitte wiederholen Sie den Befehl.“).

Sprachmodelle von emagine im Einsatz in Fahrzeugen

Seit 2019 beraten und begleiten wir führende Automobil- und Softwarehersteller für Sprachtechnologie in der Umsetzung von Sprachsteuerung in Fahrzeugen. In enger technische Abstimmung mit der Entwicklungsabteilung des Kunden hat emagine alle Sprachmodelle in den aktuellen Fahrzeugen des zweitgrößten Automobilherstellers der Welt entwickelt und unterstützt den Weltmarktführer für Spracherkennungssoftware. Das System arbeitet in 17 Sprachen nahezu fehlerfrei!

Unser eigens für den Kunden zusammengestelltes Team aus NLU-/NLP-ExpertInnen, ComputerlinguistInnen, Machine Learning SpezialistInnen, Data Scientists und MuttersprachlerInnen unter Führung eines Technical Lead, deckt derzeit 17 führende Sprachen der Welt ab. Die kaufmännische und technische Steuerung des Teams und des Projekts obliegt zu 100 % emagine.

Unser Serviceportfolio umfasst:

Data Science

- Individuelle Datensammlung

- Transkription in Text

- Datenannotation

- Datenverwaltung und -pflege

Entwicklung & Machine Learning

- Entwicklung von NLU-/NLP-regelbasierten Systemen

- Training und Testing der Automatischen Spracherkennung anhand von Sprachmodellen

- Fehleranalyse & -behebung

- Verbesserung und Upgrade existierender Sprachassistenten in 17 Sprachen

Unser System arbeitet in 17 Sprachen nahezu fehlerfrei!

Unser System arbeitet in 17 Sprachen nahezu fehlerfrei!

Mladen Turkovic, Technischer Projektleiter und Subject Matter Expert bei emagine

Ausblick & Trends

Das Potential für Spracherkennung und Infotainment in Fahrzeugen ist enorm! Sprachtechnologie im Auto wird sich zügig für eine breite Masse an Menschen vom „nice-to-have“ zum geforderten Standard entwickeln. Sprachassistenten werden die vorherrschende Methode zur Bedienung von Fahrzeugfunktionen während der Fahrt sein.

Trend #1: One for all. In Zukunft werden verschiedene Personen im Fahrzeug gleichzeitig einen Sprachassistenten nutzen können, zum Beispiel um Einstellungen im Fahrzeug individuell zu regeln.

Trend #2: User Experience. Cockpit-Assistenten werden schon bald – zusätzlich zu den Kernfunktionen Kommunikation und Unterhaltung – eine echte User Experience bieten. Das Autofahren wird künftig ein Smartphone-ähnliches Erlebnis – nur eben auf der Straße. Unterwegs Essen bestellen oder ein Kinoticket buchen – die Möglichkeiten sind grenzenlos – in jeder Sprache. Hello Car!

Trend #3: Vernetzung. Verschiedene Sprachassistenten werden über mehrere Geräte hinweg mehr und mehr vernetzt werden. Es wird möglich sein, Smart-Home-Geräte vom Auto aus zu steuern, ob Licht, Heizung, Markisen oder das Garagentor. Befehle werden fehlerfrei den jeweiligen Geräten oder Bereichen zugeordnet.

Trend #4: Machine Learning Intelligente Sprachassistenten werden so programmiert, dass sie ständig dazulernen. Je mehr smarte Sprachassistenten uns zuhören, umso besser erkennen sie zum Beispiel sprachliche Muster. Spracheingaben werden als „Trainingsmaterial“ in die Datenbank eingespielt und mit komplexen statistischen Modellen ausgewertet. Das System erkennt bestehende oder neue Muster und wird so immer besser.

Weiterlesen:

Mehr Projekt-Insights